جزئیات مقاله

ALIGNING TEXT-TO-IMAGE DIFFUSION MODELS WITH REWARD BACKPROPAGATION

مشخصات مقاله

- نویسنده مقاله: Mihir Prabhudesai, Anirudh Goyal, Deepak Pathak, Katerina Fragkiadaki

- نام دانشگاه یا موسسه: 1. Carnegie Mellon University 2. Google DeepMind

- تاریخ انتشار: اکتبر 2023

- DOI یا لینک مقاله اصلی: https://arxiv.org/abs/2310.03739

- نوع مقاله: پیشچاپ (Preprint) در arXiv

- موضوع مقاله: بهینهسازی مدلهای انتشار متن به تصویر با استفاده از گرادیان پاداش

- تعداد صفحات: 15 صفحه

- رتبه علمی ژورنال: هنوز منتشر نشده

- زبان مقاله: انگلیسی

کلمات تخصصی و توضیحات:

- Downstream tasks: وظایف یا کاربردهایی که پس از آموزش مدل اصلی به آن پرداخته میشوند، مانند تطبیق متن و تصویر یا بهبود کیفیت تصویر. این وظایف معمولاً نیازمند تنظیم دقیق مدل (fine-tuning) هستند.

- Gradient estimators: ابزارهای محاسباتی برای برآورد گرادیان در مدلهای یادگیری، که در یادگیری تقویتی نقش مهمی ایفا میکنند. این ابزارها در روشهای معمول یادگیری تقویتی اغلب واریانس بالایی دارند، که دقت را کاهش میدهد.

- End-to-end backpropagation: یک روش بهینهسازی که گرادیانها را از خروجی نهایی مدل تا ورودی اولیه، بهطور مستقیم و پیوسته انتقال میدهد. این روش باعث بهبود کارایی مدل میشود.

- Denoising process: فرآیندی در مدلهای انتشار که طی آن نویز به تدریج از یک تصویر حذف میشود تا تصویر نهایی بازسازی شود.

- Over-optimization: به معنای تنظیم بیشازحد مدل برای یک هدف خاص، که میتواند باعث کاهش توانایی مدل در تعمیمپذیری شود.

- Reward functions: توابعی که میزان موفقیت مدل در دستیابی به یک هدف خاص را اندازهگیری میکنند. در این مقاله، این توابع معیارهایی مانند کیفیت تصویر یا همترازی متن و تصویر را ارزیابی میکنند.

ترجمه:

مدلهای انتشار متن به تصویر (Text-to-image diffusion models) اخیراً به عنوان یکی از پیشرفتهترین روشها در تولید تصویر (image generation) مطرح شدهاند که از مجموعه دادههای آموزشی بسیار بزرگ و بدون نظارت یا با نظارت ضعیف بهره میبرند. به دلیل روش آموزشی بدون نظارت این مدلها، کنترل رفتار آنها در وظایف پاییندستی (Downstream tasks) مانند به حداکثر رساندن کیفیت تصویر از دیدگاه انسانی، همترازی متن و تصویر، یا تولید تصاویر اخلاقی دشوار است.

تحقیقات اخیر این مدلها را با استفاده از توابع پاداش پاییندستی (Reward functions) و روشهای یادگیری تقویتی معمولی تنظیم میکنند. این روشها به دلیل واریانس بالای برآوردگرهای گرادیان (Gradient estimators) ناکارآمد هستند یا تنها چند مرحله از تابع پاداش را برای بهروزرسانی وزنها استفاده میکنند که منجر به کمآموزی مدل نسبت به مدل پاداش میشود.

در این مقاله، ما AlignProp را معرفی میکنیم؛ روشی که مدلهای انتشار را به توابع پاداش پاییندستی همتراز میکند. این روش از انتشار گرادیان انتها به انتها (End-to-end backpropagation) از طریق تعداد تصادفیای از مراحل فرآیند حذف نویز (Denoising process) استفاده میکند تا از بیشبهینهسازی (Over-optimization) جلوگیری شود.

ما AlignProp را در تنظیم مدلهای انتشار برای اهداف مختلف، از جمله همترازی متن و تصویر، زیباییشناسی، فشردهسازی، و کنترل تعداد اشیاء موجود در تصویر و همچنین ترکیب این اهداف آزمایش کردیم. نتایج نشان میدهد که AlignProp در تعداد کمتری از مراحل آموزشی به پاداشهای بالاتری میرسد و در عین حال از نظر مفهومی سادهتر است، که آن را به انتخابی سرراست برای بهینهسازی مدلهای انتشار برای توابع پاداش قابل تفکیک تبدیل میکند. نتایج تصویری بیشتر در این لینک موجود است.

کلمات تخصصی و توضیحات:

- Adaptation steps: مراحلی که در طی آن مدل برای تطبیق با یک تابع پاداش خاص بهینهسازی و بهروزرسانی میشود.

- Concept removal: فرآیندی که مدل را ملزم به حذف یا نادیده گرفتن یک مفهوم مشخص در خروجی تولید شده میکند، حتی اگر در ورودی به آن اشاره شده باشد.

- Human-preference alignment: روشی برای تنظیم مدل بر اساس ترجیحات انسانی که از رتبهبندیهای افراد برای جفتهای متن و تصویر استفاده میکند.

- Epoch: یک تکرار کامل از پردازش کل دادههای آموزشی توسط مدل، که به ارزیابی و بهینهسازی عملکرد مدل کمک میکند.

- Diffusion model output: خروجی اولیه تولید شده توسط مدلهای انتشار پیش از اعمال مراحل تطبیق یا بهینهسازی.

- Text-to-image prompt: یک ورودی متنی که هدف آن راهنمایی مدل برای تولید تصویری مرتبط و هماهنگ با متن است.

ترجمه:

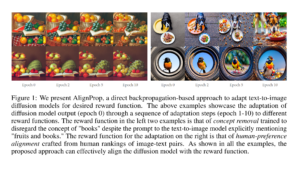

شکل 1: ما AlignProp را ارائه میدهیم، رویکردی مبتنی بر انتشار گرادیان مستقیم (direct backpropagation-based approach) برای تطبیق مدلهای انتشار متن به تصویر (diffusion models) با تابع پاداش دلخواه (reward function). نمونههای بالا تطبیق خروجی اولیه مدل انتشار (diffusion model output) در epoch 0 را از طریق یک دنباله از مراحل تطبیق (adaptation steps) به توابع پاداش مختلف نشان میدهند.

تابع پاداش در دو مثال سمت چپ برای حذف یک مفهوم (concept removal) طراحی شده است؛ به گونهای که مفهوم “کتابها” در خروجی مدل انتشار نادیده گرفته شود، حتی با وجود اینکه در متن ورودی (text-to-image prompt) بهصراحت “میوهها و کتابها” ذکر شده است. تابع پاداش برای مثال سمت راست به همترازی با ترجیحات انسانی (human-preference alignment) اختصاص یافته است، که از رتبهبندیهای انسانی برای جفتهای متن و تصویر تشکیل شده است.

همانطور که در تمامی مثالها نشان داده شده است، روش پیشنهادی میتواند مدل انتشار (diffusion model) را بهطور مؤثر با تابع پاداش همتراز کند.

کلمات تخصصی و توضیحات:

- Diffusion probabilistic models: مدلهای احتمالاتی انتشار که برای مدلسازی مولد در حوزههای پیوسته استفاده میشوند. این مدلها فرآیند کاهش نویز تدریجی برای تولید دادههای واقعی را شبیهسازی میکنند.

- De facto standard: استاندارد عملی یا غیررسمی که به دلیل پذیرش گسترده در یک زمینه مشخص، بهعنوان معیار شناخته میشود.

- Generative modeling: فرآیند یادگیری توزیع دادههای ورودی برای تولید دادههای جدید مشابه.

- Downstream objectives: اهدافی که بعد از آموزش مدل اصلی دنبال میشوند، مانند زیباییشناسی یا تطبیق متن و تصویر.

- Likelihood maximization: بهینهسازی یک مدل برای بیشینه کردن احتمال دادههای مشاهدهشده در توزیع آموزشی.

- Text-to-image alignment: همترازی معنایی بین متنی که به مدل داده میشود و تصویری که مدل تولید میکند.

- Noise in pre-training datasets: نویز یا عدم قطعیت موجود در دادههای اولیه که میتواند ناشی از کیفیت پایین، سوگیری یا تناقضات در دادهها باشد.

ترجمه:

مدلهای احتمالاتی انتشار (Diffusion probabilistic models) (Sohl-Dickstein et al., 2015; Goyal et al., 2017; Ho et al., 2020a) در حال حاضر استاندارد عملی (de facto standard) برای مدلسازی مولد (generative modeling) در حوزههای پیوسته هستند. مدلهای انتشار متن به تصویر (Text-to-image diffusion models) مانند DALLE (Ramesh et al., 2022)، Imagen (Saharia et al., 2022) و Latent Diffusion (Rombach et al., 2022) با استفاده از دادههای در مقیاس وب، در خط مقدم تولید تصویر قرار دارند.

با این حال، اکثر موارد استفاده از مدلهای انتشار به اهداف پاییندستی (downstream objectives) مانند زیباییشناسی، عدالت، همترازی متن و تصویر (text-to-image alignment)، یا دستیابی به وظایف رباتیک مرتبط هستند، که تنها با بیشینهسازی احتمال در مجموعه دادههای آموزشی دستیابی به آنها دشوار است.

برای مثال، در حالی که تصاویر آموزشی ممکن است شامل دیدگاههای غیرمعمول دوربین و اشیائی باشند که تا نیمهقابلمشاهده هستند یا در مرز تصویر قطع شدهاند، کاربران انسانی معمولاً نمونههایی از تصاویر با دیدگاههای استاندارد، محتوای زیبا و عناصری که در مرکز تصویر و در فوکوس قرار دارند را ترجیح میدهند.

علاوه بر این، به دلیل نویز (noise) موجود در مجموعه دادههای پیشآموزشی، اغلب یک ناهماهنگی بین معنای تصاویر تولیدشده و متن ورودی مرتبط با آنها وجود دارد. این اتفاق به این دلیل رخ میدهد که مدلها تمایل دارند نویز، سوگیریها و ویژگیهای غیرمعمول ذاتی دادههای آموزشی را بپذیرند.

در این مقاله، ما مسئله تنظیم دقیق مدلهای انتشار (finetuning diffusion models) را برای بهینهسازی اهداف پاییندستی، در مقابل افزایش احتمال در یک توزیع داده مشخص، مورد بررسی قرار میدهیم.

کلمات تخصصی و توضیحات:

- Supervised fine-tuning: فرآیند بهبود عملکرد یک مدل از پیشآموزشدیده با استفاده از مجموعه دادههای کوچک و برچسبگذاریشده.

- Human-curated dataset: مجموعه دادههایی که توسط انسان و با هدف دستیابی به کیفیت بالا، انتخاب یا سازماندهی شدهاند.

- Human feedback: بازخورد انسانی، که از طریق رتبهبندی یا ارزیابی نمونههای تولیدشده توسط مدل بهدست میآید.

- Reward model: مدلی که ترجیحات انسانی (رتبهبندیها یا امتیازات) را به عنوان ورودی میگیرد و از آنها برای تعیین یک مقدار پاداش برای خروجی مدل استفاده میکند.

- Reinforcement learning (RL): یک روش یادگیری که در آن مدلها بر اساس پاداش یا تنبیه ناشی از عملکرد خود تنظیم میشوند.

- Policy gradients: یک روش در یادگیری تقویتی که با استفاده از گرادیانها، استراتژی (policy) مدل را بهبود میدهد.

- Actor-critic methods: رویکردهایی در یادگیری تقویتی که از دو جزء استفاده میکنند: یک “بازیگر” (actor) برای بهبود سیاست و یک “منتقد” (critic) برای ارزیابی سیاست.

- Proximal Policy Optimization (PPO): یک الگوریتم یادگیری تقویتی پیشرفته که برای پایدارسازی بهروزرسانیهای مدل استفاده میشود.

- Dense gradient: گرادیانی که در تمامی نقاط خروجی مدل (مانند پیکسلهای تصویر) اطلاعات بهینهسازی دارد.

- Vanilla reinforcement learning: رویکردهای ابتدایی و استاندارد یادگیری تقویتی، که اغلب دارای محدودیتهایی مانند واریانس بالای گرادیانها هستند.

ترجمه:

سادهترین روش برای تطبیق مدلهای از پیشآموزشدیده با اهداف پاییندستی (downstream objectives)، تنظیم دقیق بهصورت نظارتشده (supervised fine-tuning) با استفاده از یک مجموعه داده کوچک و انتخابشده توسط انسان (human-curated dataset) از پاسخهای باکیفیت مدل است (Ouyang et al., 2022; Lee et al., 2023). با این حال، جمعآوری دادههایی که ویژگیهای مطلوبی مانند زیباییشناسی، عدالت و همترازی متن و تصویر (text-to-image alignment) را نمایش دهند، نهتنها دشوار است، بلکه این دادهها بهراحتی ممکن است دچار سوگیری شوند.

به همین دلیل، بازخورد انسانی (human feedback) اغلب با درخواست از انسانها برای رتبهبندی نمونههای رفتار مدل جمعآوری میشود. روشهای پیشین یک مدل پاداش (reward model) را بر اساس ترجیحات نسبی یا امتیازات مطلق انسانی تنظیم کرده و سپس از یادگیری تقویتی (reinforcement learning) با استفاده از گرادیان سیاست (policy gradients)، مانند روشهای بازیگر-منتقد (actor-critic methods) (Sutton et al., 1999) یا بهینهسازی سیاست مجاور (PPO) (Schulman et al., 2017)، برای تنظیم دقیق مدل انتشار استفاده میکنند تا پاسخهای با پاداش بالا تولید کنند، بدون اینکه به طور چشمگیری از مدل اصلی فاصله بگیرند (Black et al., 2023; Lee et al., 2023; Ziegler et al., 2020; Stiennon et al., 2020).

اگرچه تابع پاداش تنظیمشده (fitted reward function) قابل تفکیک است، روشهای RL مورداستفاده از گرادیانهای متراکم (dense gradient) نسبت به تصویر RGB تولیدشده استفاده نمیکنند. در نتیجه، یادگیری تقویتی ابتدایی (vanilla reinforcement learning) به دلیل گرادیانهای با واریانس بالا شناخته شده است که فرآیند تنظیم مدل انتشار را با مشکل مواجه میکند.

کلمات تخصصی و توضیحات:

- End-to-end backpropagation: انتشار گرادیان مستقیم از خروجی مدل تا ورودی آن، که امکان بهینهسازی مستقیم مدل را فراهم میکند.

- AlignProp: روشی برای همترازی مدلهای انتشار با توابع پاداش از طریق انتشار گرادیان مستقیم.

- Denoising inference: فرآیند پیشبینی و تولید تصویر با حذف تدریجی نویز از یک نمونه داده.

- Differentiable recurrent policy: یک سیاست تکرارشونده و قابل تفکیک که ورودیها را به خروجیهای مطلوب نگاشت میدهد.

- Low-rank adapter weights: وزنهایی که برای بهینهسازی مدل با حداقل تغییرات در ساختار اصلی اضافه میشوند.

- Gradient checkpointing: تکنیکی برای کاهش مصرف حافظه در فرآیند آموزش مدل، با محاسبه گرادیانها در زمان مورد نیاز بهجای ذخیره آنها.

- Truncated backpropagation: انتشار گرادیان با قطع کردن زنجیره محاسبات در یک مرحله خاص برای جلوگیری از مسائل بهینهسازی بیشازحد.

- Reward collapse: وضعیتی که در آن مدل بهصورت غیرمعمولی بهینهسازی میشود و فقط یک معیار خاص را به شدت بیشینه میکند، که منجر به کاهش توانایی تعمیم میشود.

ترجمه:

در این کار، ما نشان میدهیم که انتشار گرادیان مستقیم (end-to-end backpropagation) از گرادیانهای پاداش به وزنهای مدل انتشار ممکن است و منجر به همترازی بسیار بهتر مدل با هدف موردنظر میشود. ما روشی به نام Alignment by Backpropagation (AlignProp) را معرفی میکنیم که فرآیند پیشبینی حذف نویز (denoising inference) در مدلهای انتشار متن به تصویر را بهصورت یک سیاست تکرارشونده و قابل تفکیک (differentiable recurrent policy) ارائه میدهد.

این سیاست بهطور مؤثر ورودیهای شرطی و نویز نمونهبرداریشده را به تصاویر خروجی نگاشت میدهد و وزنهای مدل حذف نویز را با استفاده از انتشار گرادیان مستقیم (end-to-end backpropagation) از طریق توابع پاداش قابل تفکیک، که به تصویر تولیدشده اعمال میشود، تنظیم میکند.

معماری اصلی مدلهای انتشار از طریق یک دنباله از تبدیلهای تصادفی، بهطور تکراری نمونه دادهها را پالایش میکند. اگرچه تابع پاداش یادگرفتهشده قابل تفکیک است، بهروزرسانی مدل انتشار از طریق زنجیره طولانی نمونهبرداری انتشار (diffusion sampling) ساده نیست، زیرا نیازمند منابع حافظه بسیار زیادی برای ذخیره مشتقات جزئی تمامی لایههای عصبی و مراحل حذف نویز است. برای مقیاس مدلهای انتشار مدرن، این نیاز میتواند به چندین ترابایت حافظه GPU برسد (Wallace et al., 2023).

ما به جای تنظیم وزنهای اصلی مدل، وزنهای آداپتور کمرتبه (low-rank adapter weights) را که به U-Net حذف نویز اصلی اضافه شدهاند، تنظیم میکنیم و از تکنیک gradient checkpointing برای محاسبه مشتقات جزئی در زمان موردنیاز، بهجای ذخیره تمامی آنها بهصورت همزمان استفاده میکنیم. به این ترتیب، AlignProp هزینه حافظه معقولی ایجاد میکند، در حالی که هزینه پردازشی هر گام آموزشی را فقط دو برابر میکند. این هزینه با نیاز به تعداد گامهای آموزشی کمتر به دلیل بهینهسازی مستقیم جبران میشود.

در نهایت، انتشار کامل گرادیان در طول زمان (full backpropagation through time) تمایل دارد مدل را بهشدت بهینهسازی کند تا تابع پاداش را بیشینه کند، که منجر به مسئلهای به نام فروپاشی پاداش (reward collapse) میشود. ما این مسئله را با استفاده از randomized truncated backpropagation، یعنی نمونهگیری تصادفی مرحله حذف نویز که تا آن مرحله گرادیان پاداش انتشار مییابد، حل میکنیم.

![]()

کلمات تخصصی و توضیحات:

- ReFL: یک روش برای انتشار گرادیان از طریق تابع پاداش قابل تفکیک به پارامترهای مدل انتشار، اما فقط با انتشار گرادیان در یک مرحله.

- DRAFT-LV: روشی که گرادیانها را در یک تعداد ثابت از مراحل فرآیند حذف نویز (denoising process) منتشر میکند و از تکنیکهای بهینهسازی حافظه مانند checkpointing و LoRA بهره میبرد.

- LoRA finetuning: تنظیم دقیق وزنهای آداپتور کمرتبه بهجای وزنهای اصلی مدل، که به بهینهسازی حافظه کمک میکند.

- Checkpointing: تکنیکی که گرادیانها را به صورت موقت ذخیره نمیکند و به جای آن، در هنگام نیاز دوباره محاسبه میشود تا مصرف حافظه کاهش یابد.

- Semantic alignment: همترازی معنایی بین محتوای متن و تصویر تولید شده.

- High frequency details: جزئیات دقیق تصویر مانند لبهها و بافتها که در مراحل نهایی فرآیند حذف نویز به تصویر اضافه میشوند.

- Convex combinations: ترکیب خطی وزنهای مدلهای مختلف به شکلی که وزنهای ترکیب همیشه مثبت بوده و مجموع آنها برابر با 1 باشد.

- Ablation study: روشی در پژوهش برای آزمایش اهمیت بخشهای مختلف یک مدل یا طراحی خاص از طریق حذف یا تغییر آنها.

ترجمه:

کار ما از ReFL (Xu et al., 2023) و DRAFT-LV (Clark et al., 2023) الهام گرفته است. ReFL (Xu et al., 2023) اولین پژوهشی بود که انتشار گرادیان از طریق یک تابع پاداش قابل تفکیک به پارامترهای مدل انتشار (diffusion model parameters) را انجام داد، اما فقط این گرادیانها را در یک مرحله منتشر میکرد. DRAFT-LV (Clark et al., 2023) گرادیانها را در یک تعداد ثابت از مراحل فرآیند حذف نویز (K timesteps) منتشر میکرد و برای کاهش مصرف حافظه، از تکنیکهای checkpointing و LoRA finetuning استفاده میکرد.

AlignProp گرادیانها را بهصورت کامل در طول زمان (full backpropagation through time) منتشر میکند و همچنین از checkpointing و LoRA finetuning بهره میبرد، همانطور که در پژوهشهای (Black et al., 2023؛ Clark et al., 2023) معرفی شده است.

ما AlignProp را برای تنظیم دقیق مدل StableDiffusion (Rombach et al., 2022) آزمایش کردیم تا اهدافی مانند کیفیت زیباییشناسی، همترازی معنایی متن و تصویر (semantic alignment) و تنظیم حضور اشیاء را بهینه کند، همانطور که در شکل 1 نشان داده شده است. نتایج نشان میدهند که این روش پاداشهای بالاتری را به دست میآورد و نسبت به جایگزینهای مبتنی بر یادگیری تقویتی (reinforcement learning) (Black et al., 2023؛ Lee et al., 2023) بیشتر توسط کاربران انسانی ترجیح داده میشود.

ما انتخابهای طراحی مدل پیشنهادی را در یک مطالعه ablation تحلیل کرده و نشان دادیم که انتشار گرادیان از طریق زنجیره حذف نویز (denoising chain) در تعداد متغیر مراحل بسیار مهم است. همچنین نشان دادیم که لایههای تنظیمشده در مراحل اولیه حذف نویز محتواهای معنایی (semantic content) را همتراز میکنند، در حالی که لایههای تنظیمشده در مراحل نهایی حذف نویز جزئیات دقیق (high frequency details) را برای دستیابی به هدف پاییندستی (downstream objective) تنظیم میکنند.

در نهایت، نشان دادیم که ترکیبهای خطی محدب (convex combinations) از وزنهای مدلهای تنظیمشده، ترکیب توابع پاداش مربوطه را بهینه میکنند. کدها و مدلهای ما به صورت عمومی در دسترس هستند: لینک GitHub.

کلمات تخصصی و توضیحات:

- Denoising diffusion models: مدلهایی برای تولید داده که با حذف تدریجی نویز از نمونههای اولیه، دادههایی با کیفیت بالا تولید میکنند.

- 3D shapes: دادههایی که ساختارهای سهبعدی مانند مدلهای هندسی را نمایش میدهند.

- Downstream tasks: وظایف یا اهدافی که پس از آموزش اولیه مدل دنبال میشوند، مانند همترازی متن و تصویر.

- Conditional input prompts: ورودیهایی که برای راهنمایی مدل در تولید خروجیهای خاص، بهعنوان شرط استفاده میشوند.

- Cross attention layers: لایههایی که ارتباط بین متن و تصویر را برای تطبیق بهتر دادهها در مدلهای انتشار مدیریت میکنند.

- Reward-weighted likelihood: تنظیم مدل با وزندهی به احتمالهای خروجی بر اساس مقدار پاداش تخصیصیافته.

- Reinforcement learning (RL): یادگیری تقویتی، که در آن مدل با دریافت پاداش یا تنبیه، استراتژی خود را بهبود میبخشد.

- End-to-end backpropagation: انتشار گرادیان بهصورت مستقیم از خروجی تا ورودی مدل برای تنظیم دقیق وزنها.

- Q function: تابعی در یادگیری تقویتی که ارزش بلندمدت یک وضعیت یا اقدام را برآورد میکند.

- Randomized truncated backpropagation: قطع کردن زنجیره انتشار گرادیان در یک نقطه تصادفی برای کاهش مسائل ناشی از بهینهسازی بیشازحد.

ترجمه متن:

مدلهای انتشار حذف نویز (Denoising diffusion models) (Sohl-Dickstein et al., 2015; Goyal et al., 2017; Ho et al., 2020a) بهعنوان یک کلاس مؤثر از مدلهای مولد برای حوزههایی مانند تصاویر (Ramesh et al., 2021; Rombach et al., 2022; Saharia et al., 2022)، ویدیوها (Singer et al., 2022; Ho et al., 2022a;b)، اشکال سهبعدی (3D shapes) (Zeng et al., 2022)، و مسیرهای ربات یا وسایل نقلیه (Ajay et al., 2023; Pearce et al., 2023; Chi et al., 2023; Tan et al., 2023) مطرح شدهاند.

جالب توجه است که این مدلها برای تولید متن (Lovelace et al., 2022; Lin et al., 2023) نیز بهکار گرفته شدهاند و در وظایف تشخیصی مانند طبقهبندی تصویر (Li et al., 2023; Prabhudesai et al., 2023) نیز مفید واقع شدهاند. مدلهای انتشار معمولاً با استفاده از مجموعه دادههای بسیار بزرگ و بدون نظارت یا نظارت بسیار ضعیف پیشآموزش داده میشوند و سپس برای بهبود عملکرد در وظایف پاییندستی (downstream tasks) و تطبیق با اهداف کاربران تنظیم میشوند.

برخی روشهای تنظیم این مدلها پارامترهای مدل انتشار را تغییر نمیدهند. بهجای آن، ورودیهای شرطی (conditional input prompts) را بهینهسازی میکنند (Hao et al., 2022; Gal et al., 2022; Kumari et al., 2023)، لایههای توجه متقابل (cross attention layers) را برای بهبود همترازی متن و تصویر دستکاری میکنند (Feng et al., 2023)، یا از گرادیانهای یک طبقهبندیکننده پیشآموزشیافته برای راهنمایی نمونهبرداری استفاده میکنند (Dhariwal & Nichol, 2021). همچنین از راهنمایی بدون طبقهبندی (classifier-free guidance) با ترکیب مدلهای شرطی و بدون شرط بهره میبرند (Ho & Salimans, 2021).

روشهای دیگر، پارامترهای مدل را با استفاده از مجموعه دادههای کوچک انسانی یا برچسبهای انسانی مطلق یا نسبی از کیفیت پاسخهای مدل تنظیم میکنند (Lee et al., 2023; Black et al., 2023; Wu et al., 2023b; Dong et al., 2023). این روشها ابتدا یک تابع پاداش عصبی (neural network reward function) را با استفاده از امتیازات انسانی یا ترجیحات نسبی تنظیم کرده و سپس مدل انتشار را با استفاده از احتمال وزنی پاداش (reward-weighted likelihood)، احتمال فیلترشده پاداش (reward-filtered likelihood) یا یادگیری تقویتی (مانند PPO) تنظیم میکنند (Schulman et al., 2017).

در این مقاله، نشان میدهیم که مدلهای انتشار میتوانند بهطور مستقیم برای مدلهای پاداش قابل تفکیک پاییندستی (downstream differentiable reward models) با استفاده از انتشار گرادیان انتها به انتها (end-to-end backpropagation) تنظیم شوند.

کار (Xu et al., 2023) نیز انتشار گرادیان از طریق یک تابع پاداش قابل تفکیک را بررسی کرده است، اما فقط در یک مرحله از فرآیند نمونهبرداری. ما نشان میدهیم که AlignProp با انتشار گرادیان از طریق کل زنجیره نمونهبرداری عملکرد بهتری دارد. DRAFT-LV (Clark et al., 2023) پژوهش اخیر دیگری است که گرادیانها را از مدل پاداش منتشر میکند اما برخلاف ما انتشار کامل در طول زمان (full backpropagation through time) انجام نمیدهد، که ممکن است مانع از تنظیم مدل در سطح معنایی شود.

Diffusion-QL (Wang et al., 2022) انتشار کامل گرادیان در طول زمان را از یک تابع Q به یک سیاست انتشار انجام میدهد، اما تمرکز آن بر یادگیری تقویتی آفلاین برای وظایف رباتیک است، در حالی که ما بر همترازی مدلهای انتشار متن به تصویر در مقیاس بزرگ متمرکز هستیم. علاوه بر این، برخلاف Diffusion-QL، انتشار کامل گرادیان در طول زمان باعث فروپاشی مدل میشود، و برای کاهش این مسئله ما از انتشار گرادیان تصادفی و محدود (randomized truncated backpropagation) استفاده میکنیم.

کلمات تخصصی و توضیحات:

- Diffusion Models: مدلهایی که توزیع احتمالی دادهها را از طریق فرآیند انتشار یاد میگیرند، شامل افزودن و حذف تدریجی نویز.

- Forward diffusion process: فرآیندی که نویز را به نمونههای اصلی اضافه میکند تا دادهها را بهصورت تصادفی پراکنده کند.

- Reverse diffusion process: فرآیندی که نویز اضافهشده در فرآیند پیشرو را به تدریج حذف کرده و دادههای اصلی را بازسازی میکند.

- Variance schedule: زمانبندی تغییرات واریانس که مقدار نویز افزودهشده در هر مرحله از فرآیند انتشار را تنظیم میکند.

- Conditioning signal: اطلاعات اضافی مانند توضیحات تصویر یا دستهبندی که به مدل کمک میکند خروجی خود را بر اساس یک شرط خاص تولید کند.

- Text-conditioned image diffusion models: مدلهای انتشار تصویر که از متن بهعنوان ورودی شرطی برای تولید تصاویر استفاده میکنند.

- Objective function: تابع هدفی که مدل با استفاده از آن آموزش داده میشود تا خطاها را کاهش دهد و عملکرد بهینهای داشته باشد.

ترجمه متن:

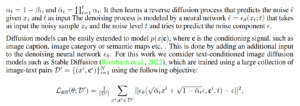

برای اصلاح مشکل بولد شدن غیرضروری در بخشهای لاتکس، کافی است متن و فرمولها را بدون استفاده از دستورات اضافی که ممکن است باعث بولد شدن شوند، ساده و مینیمال بنویسید. در زیر، متن ترجمهشده با فرمولهای اصلاحشده و بدون بولدشدگی غیرضروری ارائه شده است.

متن اصلاحشده برای Mathjax-Latex

ابتدا مواد پیشزمینه را در بخش 3 بررسی میکنیم و جزئیات روش خود را در بخش 4 ارائه میدهیم.

مدلهای انتشار (Diffusion Models):

مدل انتشار، توزیع احتمالی

را از طریق معکوس کردن فرآیندی یاد میگیرد که بهتدریج نویز را به یک نمونه

اضافه میکند. این فرآیند به نام فرآیند انتشار پیشرو (Forward diffusion process) شناخته میشود. مقدار نویز افزودهشده مطابق با زمان انتشار

و یک برنامه واریانس (

) تعیین میشود. معادله فرآیند انتشار پیشرو به شکل زیر است:

که در آن:

نمونهای از توزیع گوسی است. همچنین داریم:

سپس مدل، فرآیند حذف نویز معکوس (Reverse diffusion process) را یاد میگیرد. این فرآیند توسط یک شبکه عصبی مدل میشود که نویز

را با ورودیهای

و

پیشبینی میکند. معادله به این صورت است:

که در آن

نمونه نویزی و

سطح نویز است.

مدلهای انتشار شرطی (Conditional Diffusion Models):

مدلهای انتشار بهراحتی میتوانند برای مدلسازی

گسترش یابند. در این معادله،

یک سیگنال شرطی است (مانند توضیحات تصویر یا دستهبندی آن). این کار با افزودن ورودی

به شبکه عصبی حذف نویز انجام میشود.

در این کار، از مدلهای انتشار تصویر شرطیشده با متن مانند Stable Diffusion (Rombach et al., 2022) استفاده شده است. این مدلها با مجموعهای از جفتهای متن و تصویر

آموزش داده میشوند. هدف آموزشی این مدلها بهصورت زیر تعریف میشود:

نکات مهم:

- مشکل بولد شدن “یک” در فرمولها:

- در این نسخه، از نمادهای ساده مانند

استفاده شده است و نیازی به بولد کردن نیست.

- از نماد

\mathbf{}یا دستورات مشابه که ممکن است بولد ایجاد کنند، اجتناب شده است.

- در این نسخه، از نمادهای ساده مانند

- اندازه فرمولها:

- اگر اندازه فرمولها کوچک است، میتوانید در تنظیمات Mathjax-Latex مقدار “Scale Factor” را افزایش دهید (مثلاً به 1.5 تغییر دهید).

- پیشنمایش در وردپرس:

- متن را کپی کرده و در ویرایشگر وردپرس قرار دهید.

- پیشنمایش را بررسی کنید تا از نمایش صحیح فرمولها اطمینان حاصل کنید.

اگر همچنان مشکلی وجود دارد یا نیاز به اصلاح بیشتری دارید، لطفاً اطلاع دهید!